La crise du Covid et la pause imposée à certaines industries comme le transport aérien a soulevé une nouvelle fois l’impact néfaste de l’Homme sur son environnement et le rôle qu’il peut jouer pour préserver la planète. Face aux gros pollueurs dont l’activité est de plus en plus critiquée, il existe une pollution encore méconnue: la pollution numérique . Connue par 17% des Français selon une étude d’Inum, elle désigne la pollution liée à l’impact du numérique dans son ensemble, c’est-à-dire de sa création et sa fin de vie.

Que représente la pollution numérique par rapport à toutes les autres formes de pollution ? Quels sont les mécanismes en jeu ? Comment limiter l’impact du numérique sur la planète ?

Pollution numérique : Des chiffres surprenants

La pollution numérique est responsable de l’émission de 1400 millions de tonnes de CO2 par an, soit 4% des émissions mondiales de gaz à effet de serre. Elle est issue principalement des data center à hauteur de 25%, des infrastructures de réseau à 28% et à 47% en ce qui concerne les équipements. Il est généralement plus symbolique de comparer ces chiffres à quelque chose plutôt que de les citer. La forte augmentation d’utilisateurs et notre consommation de données laissent prévoir que d’ici 2025, cette empreinte aura doublée.

Les gestes du quotidien, pris individuellement, n’ont pas grand impact. Le problème est que ces petits gestes font partie d’une masse beaucoup plus vaste. Pour visualiser l’impact du numérique, il faut se rendre compte qu’internet c’est 45 millions de serveurs, 800 millions d’équipements réseaux, 15 milliards d’objets connectés en 2018, 10 milliards de mails envoyés (hors spam) et 180 millions de requêtes en 1 heure.

Voici ce que des gestes anodins du quotidien peuvent représenter comme pollution :

- 1 mail est l’équivalent d’une ampoule basse consommation pendant 1h, alors on multiplie cela par 10 milliards.

- 1 internaute c’est 1000 requêtes par an, soit 287 000 de CO2, soit 1,5 millions de km parcourus en voiture.

- Encore plus gourmand, le streaming vidéo ! Il représente 60% des flux de données sur internet et on comprend pourquoi quand on sait que rien que Pulp Fiction pèse 200 000 fois plus lourd qu’un email sans pièce jointe.

Ces chiffres peuvent sembler exagérés, mais il s’agit bien de la réalité. Cependant, il faut noter que la plus grande part de pollution provient de la fabrication des matériels numériques et non de leur utilisation. Un téléviseur nécessite 2,5 tonnes de matières premières pour sa création, ce qui est équivalent à un aller-retour Paris Nice en avion en termes de CO2. Un ordinateur de 2kg nécessite 800 kg de matière premières. Et plus c’est petit, plus c’est polluant. Alors on vous laisse imaginer pour un smartphone.

La Data Science pour aider à réduire la pollution numérique

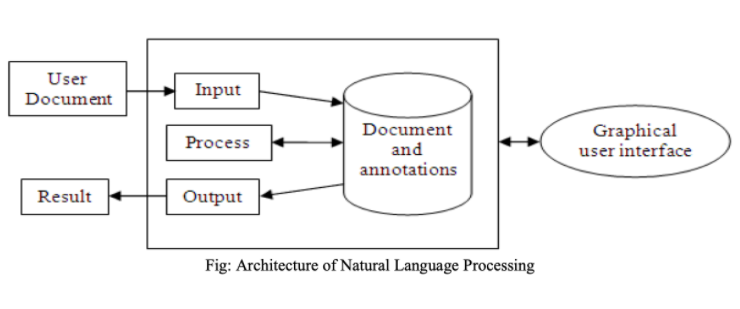

La data science a bien sûr son rôle à jouer dans tout ça. Plusieurs start-up ou entreprises font appel à cette technologie. La start-up Cleanfox a développé un outil qui vous débarrasse des spams et newsletter : «Nous avons développé des technologies nous permettant de lire les en-têtes des mails sans récupérer de données personnelles, explique Édouard Nattée, le fondateur de Cleanfox. Nous nous sommes aperçus que ces mêmes technologies pouvaient nous servir à détecter des newsletters et proposer à l’internaute de se désabonner automatiquement.». Cleanfox analyse votre boite mail et vous propose de supprimer ou non ce mail, en donnant des informations relatives tel que la quantité de CO2 entraîner par ce mail par exemple.

Comment la data science peut-elle lutter contre le réchauffement climatique ?

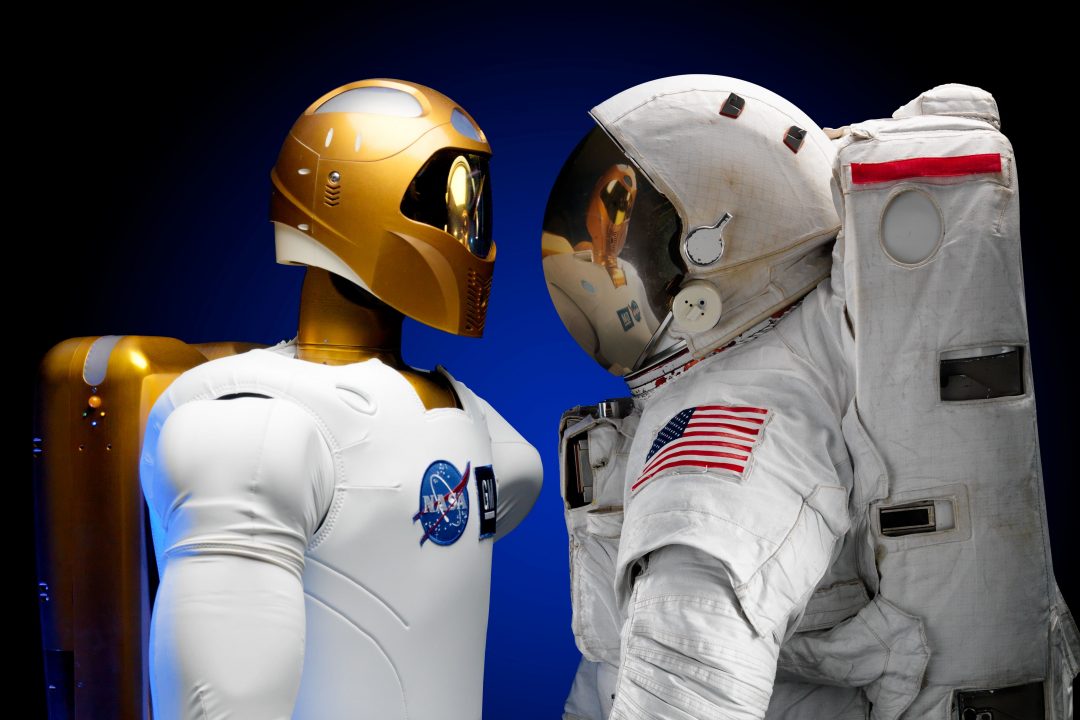

Au cœur des enjeux planétaires actuelles, le réchauffement climatique constitue un des plus grands défis de notre époque. Malgré de nombreuses politiques menées par les pays du monde entier visant à réduire les émissions de CO2, le volume d’émission de dioxyde de carbone continue de croître de manière exponentielle si bien que les chances de survies de l’Homme au sein de la planète Terre s’amenuisent de jours en jours. Toutefois, même si l’horloge tourne, l’Homme accompagné des nouvelles technologies qu’il a mis au point a encore la possibilité de sauver notre chère planète bleue. C’est dans ce contexte que l’Intelligence Artificielle et le Machine Learning pourraient devenir les défenseurs n°1 de la lutte contre le réchauffement climatique.

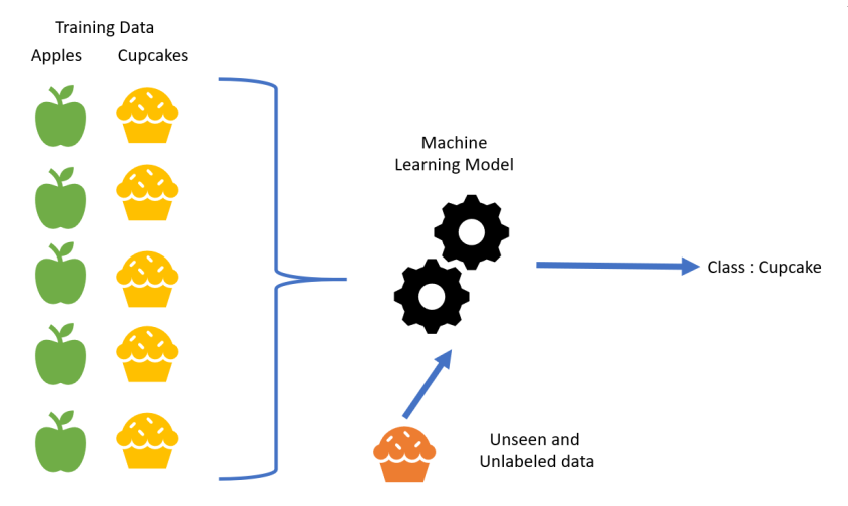

Voici le top 5 des différentes façons au travers desquelles le Machine Learning pourrait permettre de sauver la planète :

Le Machine Learning pour gérer la consommation d’énergie

De nos jours, la consommation d’énergie et des combustibles fossiles tels que le pétrole ne cessent de polluer contribuant ainsi grandement au réchauffement de la planète. Pour lutter contre cette consommation dévastatrice, les gouvernements des pays du monde entier tendent à privilégier désormais les énergies renouvelables telles que le vent ou le soleil qui, en plus d’être moins néfastes pour l’environnement, coûtent moins chers.

Néanmoins, ces sources d’énergie étant fortement dépendantes de la météo, il semble difficile pour l’Homme de déterminer la quantité exacte d’énergie qui sera produite.

Les algorithmes de Machine Learning, en analysant les données météorologiques et les conditions atmosphériques pourraient non seulement prédire le volume d’énergie généré mais également prédire la demande permettant ainsi de redistribuer la production vers les différentes centrales, tout en évitant le gaspillage.

Autre point intéressant, les nouvelles technologies permettent, sur la base de l’intelligence artificielle, de gérer la consommation d’énergie. Les assistants intelligents peuvent étudier les habitudes d’une maison et décider d’éteindre le chauffage pendant que personne n’y est et de réchauffer la maison une heure avant le retour des résidents.

La prévision de l’énergie nécessaire pour alimenter une machine, une usine, voire une ville permet de ne pas sur-produire, ainsi de ne pas gaspiller et ne pas émettre de l’énergie inutilement.

Le Machine Learning pour gérer le secteur du transport

Un autre secteur où le Machine Learning pourrait avoir impact positif retentissant est le transport. En effet, il pourrait par exemple optimiser les trajets permettant ainsi un allégement du trafic routier, un des acteurs actuels les plus polluants.

Le Machine Learning pour aider les satellites de surveillance de CO2

En vue de contrôler la quantité de CO2 émises par chaque pays européen, l’UE envisage dans les années à venir de mettre en place des satellites de surveillance de CO2. Le Machine Learning, combiné aux données récoltées par ces satellites pourrait permettre d’identifier non seulement les émetteurs principaux de CO2 mais également les secteurs d’activité les plus polluants. Il sera plus facile pour un pays par exemple de déterminer les domaines sur lesquels il faudra réfléchir en priorité pour moins polluer.

Le Machine Learning pour aider les pays les plus vulnérables au réchauffement climatique

Le Machine Learning, en étudiant les données et photographies prises par les satellites, pourrait identifier les différentes régions du monde sujettes au réchauffement climatique. Cela pourrait par la même occasion permettre aux différents pays concernés d’anticiper et ainsi de mieux gérer les éventuelles catastrophes naturelles qui risquent de les frapper.

De même, une analyse en temps réel des publications via les réseaux sociaux comme Twitter ou Facebook permettraient de déterminer dans quelles régions du monde, une aide est la plus nécessaire.

Le Machine Learning pour éviter le gaspillage alimentaire

L’analyse de données massives via le Machine Learning pourrait permettre d’optimiser des processus industriels et donc de réduire les émissions polluantes. Par exemple, les fermiers pourrait recevoir en temps réel des informations sur leurs plantations pour diffuser la quantité d’eau nécessaire. Autre exemple, des entreprises spécialisés pourraient organiser la redistribution de nourriture pour éviter le gaspillage en alimentant les zones connaissant des carences.

Devenir Data Scientist pour sauver la planète

Dans cet article, vous avez pu découvrir les opportunités que les data sciences offrent pour lutter contre le réchauffement climatique au travers une meilleure gestion de l’énergie et des ressources disponibles. Pour maîtriser ces nouvelles technologies, une formation s’impose. Pourquoi ne pas choisir un organisme qui a déjà fait ses preuves pour former des data scientists de plus de 30 grands groupes français et qui ouvre désormais ses classes aux particuliers ?

Comme nous l’avons observé tout au long de cet article, la pollution numérique a un impact négatif conséquent sur l’environnement et ne cesse d’augmenter exponentiellement. La data science, de par son étude de la big data, nécessite une grande quantité de données, très polluante à conserver. Néanmoins, l’intelligence artificielle et le Machine Learning, à travers leurs capacités à s’appliquer à des domaines tels que l’énergie, le transport, le gaspillage alimentaire offrent de vastes perspectives d’avenir synonymes de lueurs d’espoirs pour la préservation de notre planète. Il convient alors aux différents gouvernements et aux entreprises de trouver un juste milieu entre l’impact négatif et l’influence positive que pourraient apporter la data science à l’environnement.